从 AI 芯片说起,一起来看芯片门类

这两年随着人工智能的火热,无论是不是开发人员,大家都对 AI 有着空前的热情。

在开发人员中,可能绝大多数人所关注的都是机器学习算法,软件库的使用,或者是 Python。但是,别忘了,复杂的机器学习算法不光是只靠软件就够了的,它需要配合强大的硬件才能大放异彩。

与 AI 算法相配套的硬件就是所谓的 AI 芯片。

目前世面上,最受人瞩目的 AI 芯片可能就是 Google 的 TPU 了。上个月,Google IO 2017 大会上,Google 发布了第二代 TPU,距离第一代 TPU 发布时隔一年。

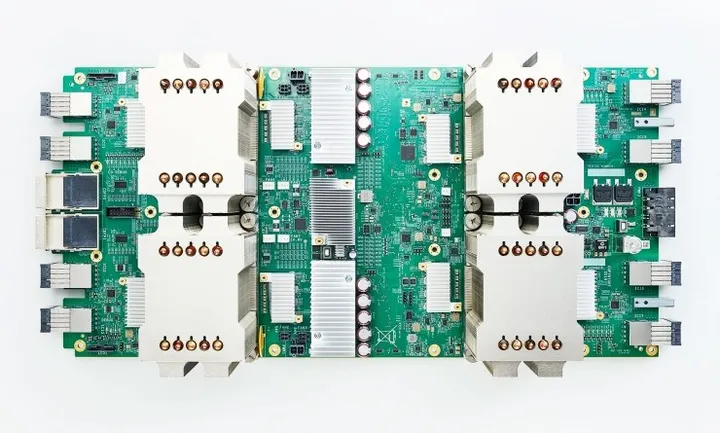

发一幅图给大家看下 TPU 的样子。

这是 Google 第二代 TPU,又称 Cloud TPU 或 TPU 2.0。它如今已经被全面部署在了 Google Compute Engine 平台上,用于图像和语音识别,机器翻译和机器人等领域。

当初轰动一时的 AlphaGo 对战李世石,硬件平台其实就用了 TPU。

这里简单说下 TPU。

它全称为 Tensor Processing Unit, 翻译成中文为张量处理器,它是 Google 的专用机器学习芯片,内部采用脉动阵列 (systolic array) 架构, 非常适用于深度学习算法中常出现的卷积运算和矩阵运算。

Google 曾刊文表示,TPU 处理速度要比 GPU 和 CPU 快 15-30 倍(和TPU 对比的是英特尔 Haswell CPU 以及 Nvidia Tesla K80 GPU),而在能效上,TPU 更是提升了 30 到 80 倍。

AI 芯片其实远远不止有 Google 的 TPU,Nvidia 的 GPU 几乎主宰了机器学习芯片市场,除此之外,Intel 以及一大批的初创公司也都在研发自己的 AI 芯片,去年的这个时候,中国首款嵌入式神经网络处理器 NPU 面世。

看到这里,我猜你有可能被各种 PU 弄晕了,那接下来,我们来看看芯片分类。

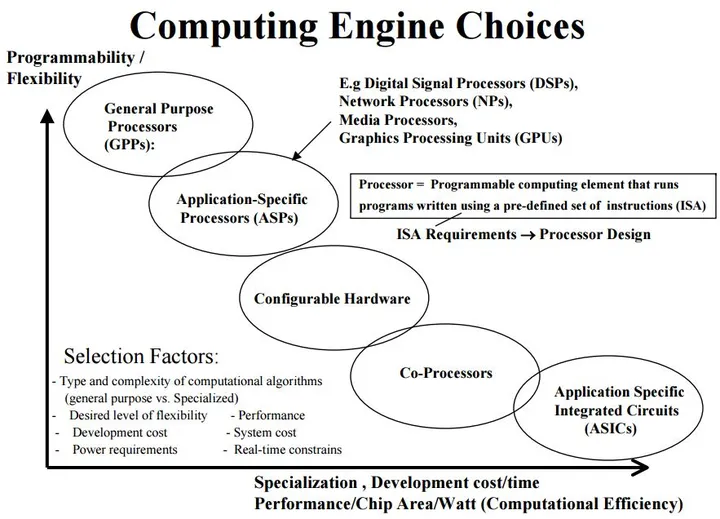

下面这幅图来自 RIT 的 Shaaban 教授的计算机体系结构课程,列出了各种 Computing Engine。

这幅图的本意是说,选择芯片的时候,需要在各个因素之间做出权衡 (灵活性,复杂性,成本,功耗,性能,实时性等),我们暂且不去讨论这个话题。

但是,我们可以从他给的这幅图,为常见的芯片做出分类。

GPP

通用处理器芯片。

例如 CPU,ARM。

ASP

专用处理器芯片。

例如 GPU,DSP,NP (Network Processor),Media Processors,Vector Processors 。

Configurable Hardware

可配置的硬件芯片。

例如 FPGA。

Co-Processors

协处理器芯片。

例如 TPU。

ASIC

专用集成电路。

例如 音视频处理芯片。

最终,回到上幅图,也可以看出各种芯片在灵活性与计算效率之间所处的位置。

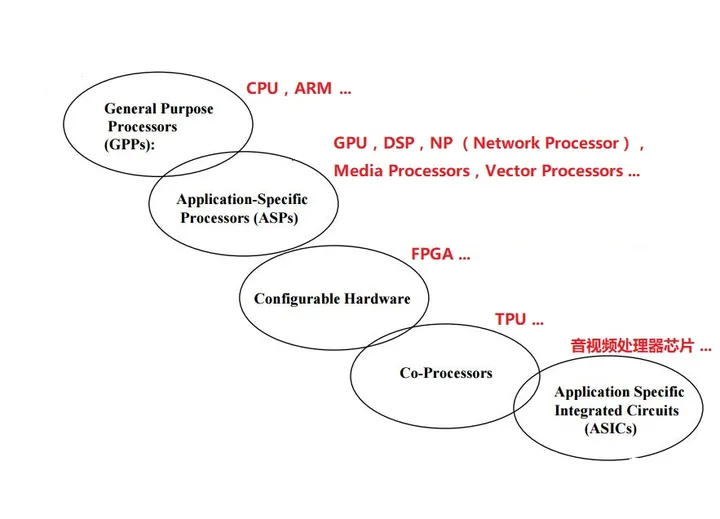

为方便理解,我把它们画进了一幅图。

最后说一下我给电类学生的一些建议吧。

人工智能的大背景下,不是人人都需要转计算机,做互联网,做软件。人工智能驱动着半导体行业发展的同时,也是半导体行业未来的发展方向。

网站声明:如果转载,请联系本站管理员。否则一切后果自行承担。

- 上周热门

- 银河麒麟添加网络打印机时,出现“client-error-not-possible”错误提示 1487

- 银河麒麟打印带有图像的文档时出错 1405

- 银河麒麟添加打印机时,出现“server-error-internal-error” 1194

- 统信操作系统各版本介绍 1116

- 统信桌面专业版【如何查询系统安装时间】 1114

- 统信桌面专业版【全盘安装UOS系统】介绍 1068

- 麒麟系统也能完整体验微信啦! 1026

- 统信【启动盘制作工具】使用介绍 672

- 统信桌面专业版【一个U盘做多个系统启动盘】的方法 616

- 信刻全自动档案蓝光光盘检测一体机 526

- 本周热议

- 我的信创开放社区兼职赚钱历程 40

- 今天你签到了吗? 27

- 信创开放社区邀请他人注册的具体步骤如下 15

- 如何玩转信创开放社区—从小白进阶到专家 15

- 方德桌面操作系统 14

- 我有15积分有什么用? 13

- 用抖音玩法闯信创开放社区——用平台宣传企业产品服务 13

- 如何让你先人一步获得悬赏问题信息?(创作者必看) 12

- 2024中国信创产业发展大会暨中国信息科技创新与应用博览会 9

- 中央国家机关政府采购中心:应当将CPU、操作系统符合安全可靠测评要求纳入采购需求 8