Python之pyspark:pyspark的简介、安装、使用方法之详细攻略

Python之pyspark:pyspark的简介、安装、使用方法之详细攻略

目录

pyspark的简介

Spark是一个用于大规模数据处理的统一分析引擎。它提供Scala、Java、Python和R中的高级api,以及一个优化的引擎,该引擎支持用于数据分析的通用计算图。它还支持一组丰富的高级工具,包括用于SQL和DataFrames的Spark SQL、用于机器学习的MLlib、用于图形处理的GraphX和用于流处理的结构化流。

Python Packaging,这个自述文件只包含与PySpark安装的pip相关的基本信息。这个打包目前还处于试验阶段,在未来的版本中可能会有变化(尽管我们会尽力保持兼容性)。使用PySpark需要Spark jar,如果您是从源代码构建它,请参阅“构建Spark”中的构建器说明。

Spark的Python打包并不打算取代所有其他用例。这个Python打包版本的Spark适合与现有集群交互(无论是Spark independent、YARN还是Mesos)—但是不包含设置自己的独立Spark集群所需的工具。您可以从Apache Spark下载页面下载完整版本的Spark。

注意:如果您在Spark独立集群中使用它,您必须确保版本(包括次要版本)匹配,否则您可能会遇到奇怪的错误。

官网:https://spark.apache.org/

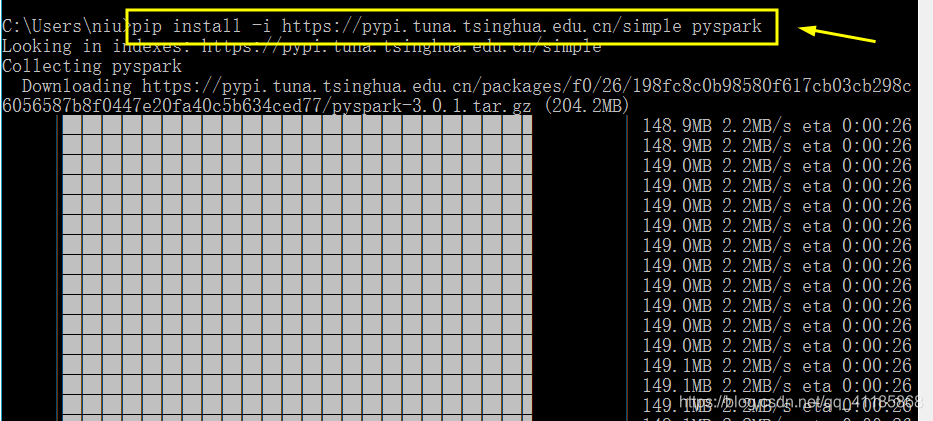

pyspark的安装

pip install pyspark

pyspark的使用方法

- from pyspark import SparkContext, SparkConf

- from pyspark.sql.session import SparkSession

-

-

- conf = SparkConf().setAppName('test_parquet')

- sc = SparkContext('local', 'test', conf=conf)

- spark = SparkSession(sc)

-

- parquetFile = r"hdfs://host:port/Felix_test/test_data.parquet"

- parquetFile = r"data.gz.parquet"

- df = spark.read.parquet(parquetFile)

- print(df.first())

文章知识点与官方知识档案匹配,可进一步学习相关知识

Python入门技能树预备知识Python简介123871 人正在系统学习中

网站声明:如果转载,请联系本站管理员。否则一切后果自行承担。

赞同 0

评论 0 条

- 上周热门

- 如何使用 StarRocks 管理和优化数据湖中的数据? 2962

- 【软件正版化】软件正版化工作要点 2881

- 统信UOS试玩黑神话:悟空 2848

- 信刻光盘安全隔离与信息交换系统 2740

- 镜舟科技与中启乘数科技达成战略合作,共筑数据服务新生态 1274

- grub引导程序无法找到指定设备和分区 1239

- 华为全联接大会2024丨软通动力分论坛精彩议程抢先看! 169

- 2024海洋能源产业融合发展论坛暨博览会同期活动-海洋能源与数字化智能化论坛成功举办 168

- 点击报名 | 京东2025校招进校行程预告 164

- 华为纯血鸿蒙正式版9月底见!但Mate 70的内情还得接着挖... 161

- 本周热议

- 我的信创开放社区兼职赚钱历程 40

- 今天你签到了吗? 27

- 信创开放社区邀请他人注册的具体步骤如下 15

- 如何玩转信创开放社区—从小白进阶到专家 15

- 方德桌面操作系统 14

- 我有15积分有什么用? 13

- 用抖音玩法闯信创开放社区——用平台宣传企业产品服务 13

- 如何让你先人一步获得悬赏问题信息?(创作者必看) 12

- 2024中国信创产业发展大会暨中国信息科技创新与应用博览会 9

- 中央国家机关政府采购中心:应当将CPU、操作系统符合安全可靠测评要求纳入采购需求 8

热门标签更多